Artikkel

Slik skal EU regulere KI-teknologi

Dette er det du trenger å vite om kappløpet mellom kunstig intelligens og reguleringer av teknologien.

Tirsdag 21. mai ga landene i EU grønt lys til den nye EU-loven som skal regulere kunstig intelligens (KI). I en pressemelding samme dag skriver EU at målet med en slik lov er å fremme utviklingen av trygge og troverdige KI-systemer over hele EU.

Litt over tre år etter at EU-rådet la fram sine forslag til regulering av KI i april 2021, ble det i desember 2023 enighet mellom landene som nå har gitt en endelig tommel opp til loven.

Men hvordan vil den historiske loven fungere i praksis? Er det dette som skal til for å beholde kontrollen over KI-utviklingen?

Sammen med pressemeldingen har EU-rådet publisert hele regelverket i et PDF-dokument på 419 sider.

EUs risikovurderinger

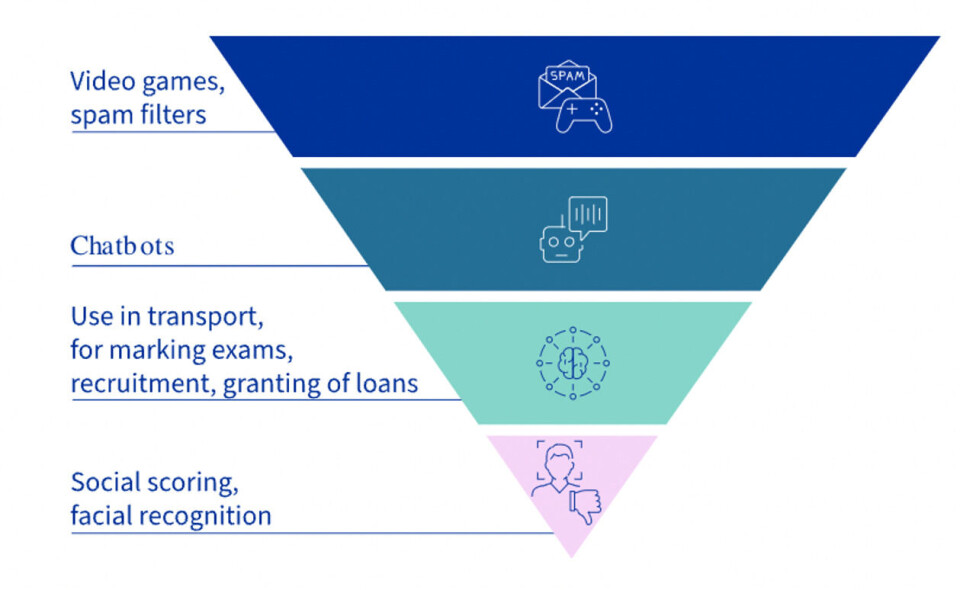

Som en del av den nye loven inngår et klassifiseringssystem som skal si noe om hva slags risiko KI-systemer utgjør.

Risikosystemet har fire forskjellige rangeringer: minimal risiko, begrenset risiko, høy risiko og uakseptabel risiko. Den omvendte pyramiden under illustrerer EUs rangering av KI-teknologier i risikosystemet.

Dersom selskaper bryter disse retningslinjene, vil de kunne bli straffet ved å måtte betale en gitt prosentandel av de globale inntektene sine for året, eller en gitt sum.

Minimal risiko:

- Dette er den største andelen av KI-systemer, som spamfiltre og videospill.

- Dette vil stort sett ikke bli regulert, og bør følge retningslinjer for å sikre etisk og sikker bruk.

Begrenset risiko:

- KI-systemer som interagerer med mennesker via chatboter, som i netthandel eller læringsbaserte KI-verktøy.

- De må kunne vise stor grad av åpenhet slik at brukere vet at de interagerer med kunstig intelligens.

Høy risiko:

- KI-systemer som utgjør høy risiko for helse, sikkerhet eller fundamentale rettigheter, som for eksempel systemer som brukes i kritisk infrastruktur, politiarbeid, migrasjon, asyl, grensekontroll og rettsforvaltning.

- Dette krever høy kvalitet på datasett og risikovurderinger, i tillegg til detaljert dokumentasjon, åpenhet, menneskelig overvåkning og jevnlig monitorering og testing.

Uakseptabelt høy risiko:

- KI-systemer som utgjør en trussel for folks sikkerhet og individuelle rettigheter vil være forbudt. Dette kan være systemer som manipulerer menneskelig oppførsel, sosiale poengsystem eller biometriske identifikasjonssystemer i offentlige rom til bruk av politimyndigheter.

- Disse systemene har potensial til å påføre betydelig skade på individer og samfunnet, og er derfor forbudt.

Nylanseringer på rekke og rad – faktafeil inkludert

Mai har bydd på nylanseringer fra to av de største aktørene innenfor KI. 13. mai lanserte OpenAI chatmodellen GPT-4o, og dagen etter kom Google med sine egne KI-oppdateringer. Dette var blant annet innenfor Google-søk, og en prototype av en kommende KI-assistent.

Kilde: OpenAI / X

OpenAI fjernet i etterkant av lanseringen den ene stemmen til KI-assistenten etter hard medfart fra skuespiller Scarlett Johansson. Hun mener selskapet har etterliknet stemmen hennes uten å innhente samtykke, og at stemmen til assistenten likner veldig på stemmen til Johansson da hun i 2013 hadde rollen som KI-assistenten i filmen «Her».

Også under Google sin lansering ble deres framtidige KI-assistent presentert. Denne funksjonen har ennå ikke blitt lansert, men ble demonstrert i form av en prototype som de ansatte fortsatt jobber med.

Men allerede i en promo-video som demonstrerer de nye KI-funksjonalitetene i søket til Google, ble det oppdaget det som skal være en feil i svaret som Google gir. Teknologiavisen The Verge var tidlig ute med å kalle Googles KI-genererte svar i søkemotoren for dårlige råd, og spesifiserte at ett av punktene, som også ble fremhevet i videoen, var faktafeil.

Hva sier EU-loven om ChatGPT?

KI-systemer som OpenAIs ChatGPT og bildegeneratoren DALL-E, blir av EU kategorisert som «general-purpose AI models» (GPAI). Ifølge den omvendte pyramiden, er dette systemer som utgjør en begrenset risiko.

Dette betyr at selskaper blant annet må kunne være åpne med brukere om systemets funksjoner.

Men EU har også vist til bekymringer knyttet til GPAI og store språkmodeller, som ChatGPT, og at de kan utgjøre en etisk og sosial risiko. Modellene kan diskriminere og handle ut ifra stereotyper og sosiale forutinntattheter basert på fordommer.

De kan også utgjøre en risiko når det kommer til personlig, sensitiv informasjon og komme med faktafeil og usannheter, som igjen kan gjøre det lettere å spre feilinformasjon.

Uenighet om framtidig sikkerhet

Denne uken avholdes et KI-toppmøte i Seoul, Sør-Korea, der 16 store KI-selskaper møter toppledere i samtaler om hvordan verden kan utvikle kunstig intelligens på en sikker måte.

Møtet er det andre av sitt slag, og er en oppfølger til møtet som fant sted i fjor ved Bletchley Park, England. På åpningsdagen av årets toppmøte kunngjorde den britiske statsministeren Rishi Sunak at samtlige av de 16 selskapene hadde sluttet seg til retningslinjene for sikkerhetsstandarder innen KI.

Dagen før selskaper og toppledere samlet seg både fysisk og virtuelt i Seoul, publiserte det vitenskapelige tidsskriftet Science en akademisk artikkel, der det hevdes at politikere verden rundt har gjort for lite innen KI-regulering.

Artikkelen, skrevet av 25 eksperter på området, anbefaler et rammeverk for sikkerheten som de mener krever tøffere retningslinjer og regler i den raske utviklingen av KI-teknologi. De mener også at nåværende initiativer ikke er nok.

Ekspertene skriver at teknologien kan være svært nyttig for menneskeheten ved at den kan bidra til å kurere sykdommer og bedre levestandard, men at KI i tillegg kan være en fare for sosial stabilitet og legge til rette for automatisert krigføring. Selv når hensikten er god, mener ekspertene at vi i verste fall kan miste menneskelig kontroll over automatiserte KI-systemer.

Samtidig publiserte også Storbritannias regjering et første utkast til rapporten «International Scientific Report on the Safety of Advanced AI» 17. mai. Her mener forskerne at det ennå ikke er bevis for at KI kan utvikle biologiske våpen eller drive sofistikerte cyberangrep, men at det er stor uenighet blant eksperter om dagens KI-situasjon og hvordan den vil eller kan utvikle seg.

Usikkerheten også merkbar i toppen av OpenAI

Tidlig i forrige uke, kun dager etter at OpenAI lanserte den nyeste versjonen av ChatGPT, hadde to sentrale ansatte i selskapet sluttet.

Den første var Ilya Sutskever som grunnla selskapet sammen med Sam Altman og jobbet som sjefsforsker i OpenAI. Sutskever sa i en uttalelse at han har full tiltro til at selskapet kommer til å lage kunstig generell intelligens (KGI) - på engelsk: artificial general intelligens (AGI) - som «både er trygg og nyttig».

KGI er en teknologi som ennå ikke er utviklet, men som viser til en type kunstig intelligens som kan «tenke» selv, på lik linje som en menneskelig hjerne.

Kilde: Jan Leike / X

Den ledende forskeren innenfor sikkerhet, Jan Leike, var den andre som sluttet i jobben sin samme uke. På X skrev den tidligere OpenAI-ansatte at sikkerhetskultur og prosess har blitt satt til side i selskapet de siste årene til fordel for «skinnende produkter».

Leike uttalte også at det å lage maskiner som er smartere enn mennesker, er en farlig virksomhet. Ifølge Leike, følger det med et ekstremt ansvar som krever at selskapet setter sikkerhet først.

Dette er ikke første gang selskapet har hatt interne problemer og uenigheter. I november 2023 ble administrerende direktør Sam Altman fjernet fra selskapet, før OpenAIs styre ble enige om å gjeninnsette Altman som sjef bare dager senere.

Ønsker storfinansiering

I USA la denne måneden en gruppe tverrpolitiske senatorer fram forslag til retningslinjer og finansiering av KI-teknologi. I senatorenes «road map» ønsker de blant annet at Kongressen skal gi grønt lys for å finansiere amerikansk KI-teknologi med 32 milliarder dollar for at landet skal ligge foran Kina i utviklingen.

Ifølge The Washington Post har forslaget fått sterk kritikk fra flere hold.

Her hjemme i Norge la regjeringen fram en plan om en nasjonal strategi for kunstig intelligens i 2020.

Når EUs nye KI-regelverk blir lov i EUs medlemsland, er det stor sannsynlighet for at forordningen også vil bli innlemmet i EØS-avtalen som Norge er en del av.