Artikkel

Kan vi stole på KI-detektorer?

Flere eksperter er skeptiske til svarene KI-detektorer gir. Hva vet vi egentlig om hvordan de fungerer?

Denne artikkelen ble publisert for over 1 år siden og kan inneholde utdatert informasjon.

KI-teknologien har for alvor skutt fart de siste årene. Kanskje mest merkbart var det da språkmodellen ChatGPT ble allemannseie mot slutten av 2022. Men også teknologien bak KI-generering av bilder og video utvikler seg nå i en voldsom fart.

Dette har blant annet gjort at KI-genererte bilder blir spredt på sosiale medier uten at det opplyses om at dette ikke er representasjon av virkeligheten. Også i tradisjonelle medier har KI-genererte bilder klart å lure redaksjoner til å publisere dem som om de er ekte. NRK publiserte i januar et bilde de trodde var tatt og sendt inn av en leser, men som viste seg å være laget av et reklamebyrå i et KI-program.

Med stadig bedre KI-generatorer har mange nå et behov for raskt å kunne finne ut om et bilde er ekte eller KI-generert, noe som har ført til at flere KI-detektorer har dukket opp. Slike detektorer skal kunne gi brukeren et svar på hvor stor sannsynligheten er for at et bilde er KI-generert.

Men fungerer egentlig disse detektorene? I hvilken grad kan vi stole på dem?

– Mister tillit

Flere fagfolk innen digital kommunikasjon er skeptiske til slike detektorer og hvorvidt vi i det hele tatt kan legge noe i svarene de gir.

Fra Media City Bergen drives prosjekt Reynir, en del av det BBC-startede Project Origin (der også norske medieaktører som TV 2, NRK, Schibsted og NTB, samt Faktisk.no er blant de mindre samarbeidspartnerne). Prosjektet er blitt til som et svar på fremveksten av generativ KI, og målet er å utvikle teknologi slik at medieaktører merker visuelt innhold – en innholdsmerking som vil komme mediebransjen til gode, også den norske.

Det er Media City Bergen-direktør Helge O. Svela som leder Reynir-prosjektet og til Faktisk.no sier Svela at han generelt er skeptisk til løsninger som skal avsløre bilder laget av generativ KI.

– Utfordringen med verktøy som skal avdekke ting som er falskt, er at det gir begrenset verdi hvis man ikke kan stole på at suksessraten er tilnærmet hundre prosent. Man mister fort tilliten når ting som man vet er ekte, merkes som falskt — og ikke minst når forfalsket informasjon slipper gjennom nåløyet, sier han.

Han mener den svekkede tilliten til det som faktisk er ekte, kan være en fare for vår demokratiske offentlighet på internett.

Rask utvikling

Tempoet i utviklingen innenfor KI-teknologien kan være en av utfordringene som gjør at slike detektorer ikke fungerer eller rett og slett blir hengende etter.

Det er ofte uklart akkurat hva slags datagrunnlag som ligger til grunn for treningen av de fleste KI-detektorer. Men jo flere KI-bilder slike detektorer kan trene seg på, jo bedre lærer de seg å kjenne dem igjen.

– Vi kan ikke gjøre noe med støyen fra generativ KI, påpeker imidlertid Helge O. Svela.

– De bildene som blir generert, kommer bare til å bli bedre og bedre, og tjenestene som skal avsløre hva som er falskt blir tvunget inn i et våpenkappløp som de dessverre nok kommer til å tape, sier han.

Han mener det ikke er støyen som bør være fokuset, men heller signalet, altså det som er ekte. Det er dette som må styrkes ifølge Svela, noe som også er kjernen i Prosjekt Reynir.

Samtidig som mange mener at vannmerking av bilder er veien å gå, har andre større tro på KI-detektorer. Blant dem er Kevin Guo, administrerende direktør for teknologiselskapet Hive Moderation som tilbyr både tekst-, bilde- og lyddetektorer.

– Vi mener at den eneste skalerbare løsningen er å bygge våre egne KI-modeller for å oppdage dette innholdet, skriver Guo i en e-post til Faktisk.no.

Guo peker også på den svært raske utviklingen og at nye generasjoner med KI-generatorer dukker opp hele tiden.

Ser ingen komplette løsninger

På Senter for digitale fortellinger ved Universitetet i Bergen er postdoktor David Jhave Johnston mer pessimistisk når det kommer til hvorvidt vi kan stole på KI-detektorer i framtiden.

– Det ser ikke ut til nå, i det utviklende økosystemet med stadig utvidende kapasiteter, at det vil være noen enkle, komplette løsninger, sier Johnston.

Han har selv også erfaring med KI-detektorer for KI-generert tekst. På dette feltet ble det juli 2023 publisert en studie som var gjort av KI-detektorer beregnet for å sjekke om tekst er KI-generert. Studien viste at tekster skrevet på engelsk av folk som ikke hadde språket som morsmål, i mange tilfeller ble feilidentifiserte som KI-genererte.

Johnston peker på at ingen av de store teknologiselskapene har klart å lage en tilstrekkelig detektor. OpenAI, selskapet bak ChatGPT, avsluttet i juli 2023 sin egen detektortjeneste fordi den var for upresis.

– Dette er egentlig ukjent terreng. Og problemet er også at det er et felt i stadig utvikling, sier Johnston.

Han mener dette er et område som er åpent for og krever forskning.

Test av KI-detektorer

En som har forsøkt å finne svaret på hvordan KI-detektorer for bilder fungerer, er Thomas Andre Fure.

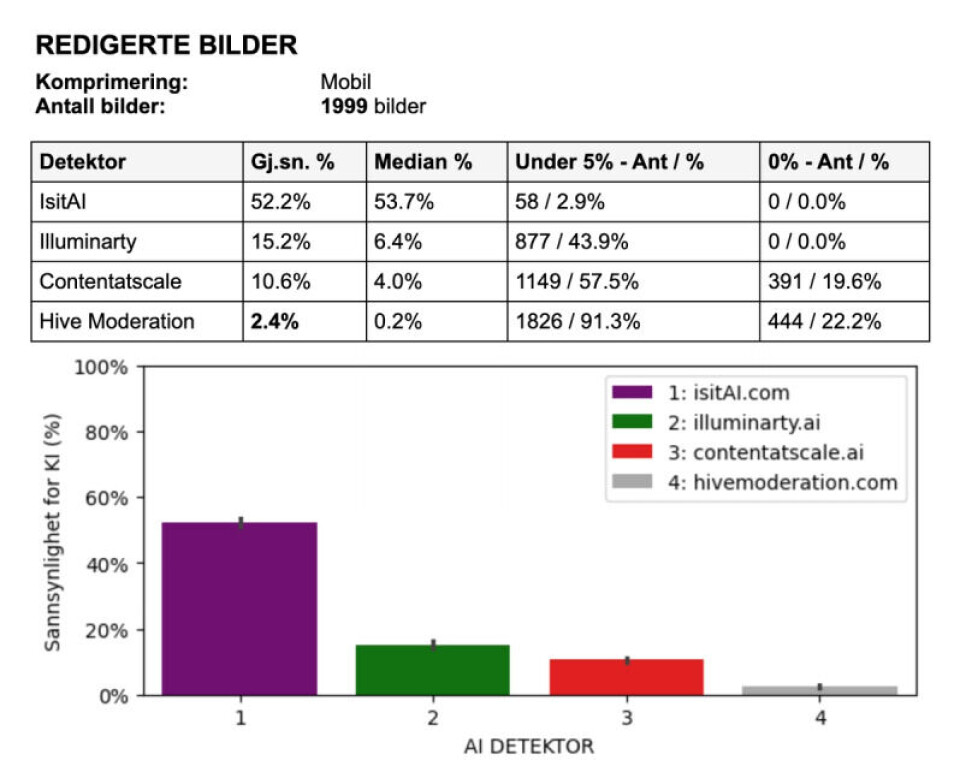

Fure er i ferd med å gjennomføre sitt andre år av en bachelor i fotojournalistikk ved OsloMet og har i den sammenheng laget en bacheloroppgave der han har testet fire forskjellige KI-detektorer; IsitAI, Illuminarty, ContentatScale og Hive Moderation.

– Det var ingen som hadde prøvd eller gjort det, så da måtte jeg gjøre det, sier han.

Heller ikke Faktisk.no har funnet tegn på at en slik undersøkelse har blitt gjort i samme skala som Fure sin når det gjelder KI-bildedetektorer. Den internasjonale faktasjekkgruppen Bellingcat gjorde i september 2023 en test av kun én av detektorene, men da med 200 bilder. The New York Times gjorde tre måneder tidligere en test av fem forskjellige detektorer, tre av de samme som Fure testet, med over hundre bilder.

Med et bildegrunnlag på rett under 6 000 bilder, gikk Fure i gang med å lage et program som kunne kjøre alle bildene gjennom de fire detektorene og lagre resultatene i en database.

Bildene som ble kjørt igjennom programmet var:

- Ekte uredigerte bilder

- Ekte redigerte bilder

- Ekte redigerte bilder med komprimering fra bilderedigeringsprogrammet Adobe Lightroom

- KI-bilder

- KI-bilder med Facebook-komprimering

- KI-bilder med Adobe Lightroom-komprimering

- Mobilbilder

Best i test

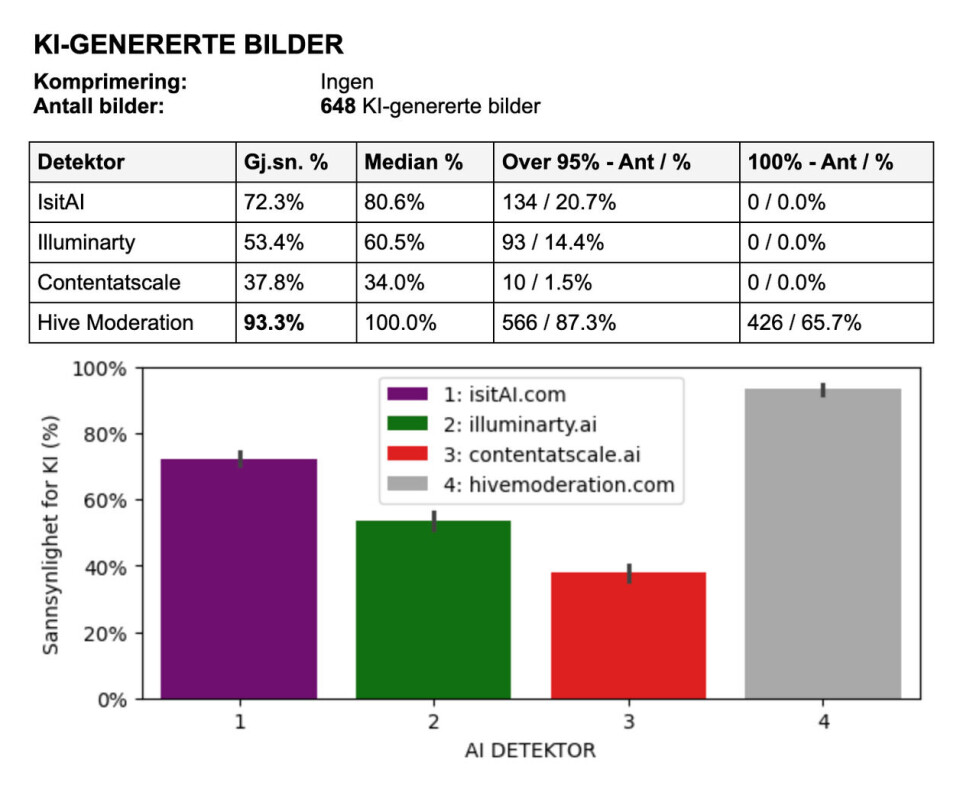

En av KI-detektorene viste seg å være klart bedre enn de andre etter at detektorene fikk prøvd seg på 648 ulike KI-genererte bilder.

Hive Moderation endte på topp og hadde en gjennomsnittlig sannsynlighetsskår på 93,3 prosent på ukomprimerte KI-bilder. Det vil si at av alle de 648 KI-genererte bildene som ble testet, var resultatet i gjennomsnitt at Hive Moderation mener det er 93,3 prosent sjanse for at bildet er KI-generert. Detektoren ga 426 av bildene 100 prosent sjanse for at de er KI-generert. Dette er stor forskjell fra de tre andre detektorene som ikke ga noen av bildene 100 prosent.

Under er resultatene fra de ukomprimerte KI-genererte bildene som Fure testet:

– Av alle de ekte bildene som jeg testet, så er det ingen som skårer 100 prosent sannsynlighet for KI, sier Fure også om Hive Moderation.

Om det er lurt å stole blindt på KI-detektoren, tror han ikke. Men Hive Moderation gjør det godt i testene og Fure mener den kan brukes som en indikator før videre verifisering gjøres.

I testen la Fure merke til at bilder fra den nyeste versjonen av Midjourney var noe vanskeligere for detektoren å oppdage som KI-generert enn fra tidligere versjoner. Midjourney er en av de store KI-generatorene som kan lage KI-bilder basert på en tekstprompt som brukeren gir den. Versjon nummer seks av Midjourney ble tilgjengelig rett før jul 2023.

– For nye versjoner tar det litt tid før mange nok bilder er generert for at detektoren har nok trening til å kunne begynne å gi gode svar. Det la jeg merke til, sier Fure.

– Avgjørende å være oppdatert

I likhet med både Svela, Jonston og Fure, mener også de som lager detektoren IsItAI.com at de største utfordringene de møter er hvor raskt utviklingen innenfor KI-generering går.

I en e-post til Faktisk.no skriver IsItAI at det er vanskelig å få et komplett datasett av høy kvalitet som inkluderer bilder laget med de nyeste KI-teknikkene.

– Etter hvert som generative KI-modeller forbedres, blir de bedre til å lage bilder som etterligner virkeligheten nærmere, noe som gjør dem vanskeligere å oppdage som KI. Det er avgjørende å holde våre detektormodeller oppdatert med disse fremskrittene, noe som innebærer kontinuerlig trening med de nyeste dataene, skriver IsItAI til Faktisk.no.

Hvordan jobber detektorene?

For å forsøke å finne ut hvordan detektorene jobber og hva de ser etter i bildene, har Fure eksperimentert med forskjellige versjoner av de «ekte» bildene for å se om det gir forskjellige resultater.

– Jeg startet med helt vanlige bilder tatt med systemkamera, helt uredigert, så lagde jeg forskjellige varianter av dem, både uredigert og redigert. Og så prøvde jeg forskjellige komprimeringer og med og uten metadata, sier Fure.

Han forteller at uredigerte og redigerte bilder ga forskjellige resultater i detektorene. Komprimerte bilder derimot ga likere svar. Med dette mener han bilder med lav kvalitet som er strippet for informasjon og lag. Også bilder som har vært gjennom Facebook og X ble testet, men dette hadde også lite å si for resultatene.

Hvordan bildene analyseres og detaljer som avgjør resultatene, var noe av det Fure forsøkte å finne ut av i prosjektet. Han undersøkte blant annet om kamerainnstillinger som lukkertid, ISO og blenderåpning hadde noe å si for de ekte bildene, regnet ut gjennomsnittet på lysstyrke per piksel og noterte seg de dominerende fargene i bildet.

– Men jeg fant ikke noe som skilte seg ut, sier Fure.

En faktor påvirket imidlertid detektorene noe i analysen av de ekte bildene.

– Bilder som var veldig over- eller undereksponert, fikk lavere sannsynlighet for KI. Men det gir kanskje mening, med tanke på at KI-bilder som regel er ganske godt eksponert.

Lite sammenheng mellom detektorsvarene

Da det var avgjort hvilken av detektorene som var klart best, ville Fure undersøke om det var en sammenheng mellom hva detektorene kategoriserte som ekte eller KI.

Testen ble gjort på alle de forskjellige bildetypene og med forskjellige eksponeringsinnstillinger for å se om det var en positiv eller negativ korrelasjon.

Men det var ingen korrelasjon å spore i resultatene. Fure sier at det ofte virket nærmest tilfeldig hva de tre detektorene som skåret lavest i undersøkelsene hans ga som prosentandel i svaret.

Også hos VG har fotograf og tidligere fotosjef Annemor Larsen eksperimentert ved å laste opp egne bilder til detektorene for å teste noen av dem. Ved noen av bildene hadde Larsen lagt på generativt fyll som legger til KI-genererte elementer i et bilde. Dette kan blant annet gjøres i Photoshop.

– Svarene jeg fikk var høyst tvilsomme, sier Larsen.

Hun mener at en KI-detektor i seg selv ikke er tilstrekkelig for å faktasjekke et bilde.

– Den kan gi veldig misvisende svar. Som med all bruk av KI må vi også når det kommer til bilder holde «humans in the loop», sier Larsen.

– Advarsel

Men til Faktisk.no skriver IsItAI at de er optimistiske for fremtiden og jobber med å gjøre detektoren mer presis.

– Ingen KI-systemer er perfekte, og vårt er intet unntak. Det er designet for å hjelpe til med å identifisere bilder generert av KI, men det fungerer best når det brukes sammen med andre evalueringsmetoder. Vi er opptatt av å kontinuerlig forbedre ytelsen ved å utvide og diversifisere datasettene detektoren lærer fra, skriver IsItAI.

Også Kevin Guo i Hive Moderation skriver til Faktisk.no at de hele tiden oppdaterer modellene sine for å tilpasse seg til nye KI-generatorer som dukker opp.

– Jeg kan ikke si noe om hva andre gjør, men vi har enorme datasett som vi har brukt til å trene modellene våre på, skriver Guo.

Faktisk.no har også forsøkt å kontakte selskapene bak KI-detektorene Illuminarty og ContentatScale, men har ikke lyktes med å komme i kontakt med dem.

Terje Lindblom er førsteamanuensis i fotojournalistikk ved OsloMet og har vært Fure sin veileder gjennom prosjektet.

Lindblom mener studien er meget viktig og midt i blinken fordi den viser at utviklingen av denne type KI-detektorer egentlig ikke har kommet så langt og ikke er nøyaktige.

– Disse funnene kan forhåpentligvis fungere som en advarsel til dem som jobber med verifisering av bilder i en bransje som er desperat etter å finne et raskt «bøtemiddel» mot en antatt flom av falske, KI-genererte bilder som allerede truer troverdigheten til journalistikken og bildene i den, sier Lindblom.

For ordens skyld: Thomas Andre Fure er samboer med en av journalistene i Faktisk.no, men vedkommende journalist har ikke vært involvert i arbeidet med denne artikkelen. Fure intervjuet to personer i Faktisk Verifiserbar til arbeidet i bacheloroppgaven.